Cohesity bietet die erste Storage-Plattform, die Datensicherung und Big-Data-Silos in einer grenzenlos skalierbaren Infrastruktur vereint Statt einer komplizierten, kostspieligen und

Monat: August 2017

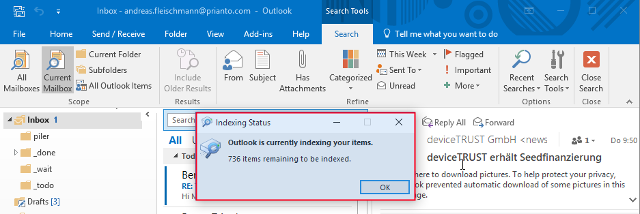

Microsoft: Suche in Outlook in non-persistent RDS Umgebungen

In einem neu erschienenen Artikel auf docs.microsoft.com namens „Dealing with Outlook search in non-persistent environments“ werden die Ergebnisse von einem

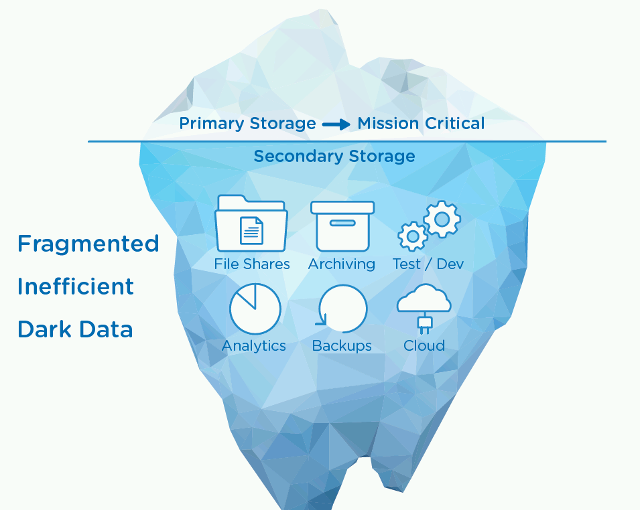

Cohesity SpanFS™ and SnapTree®

Die Mission von Cohesity ist es, den sekundären Speicher neu zu definieren. Herkömmliche Storage-Lösungen, wie zum Beispiel Dedupe-Appliances, Backup-Software und

Die IT-Asset-Optimierung harmonisiert – Anwender und IT-Abteilung im Einklang

Innerhalb vieler PCs im Unternehmen existiert ungenutztes Potenzial für Einsparungen und bessere Systemleistung. Die letzten 10 Jahre in großen Desktop-Transformationsprojekten

Kostenlose Tools für das Planen von Backups

Viele von uns verwenden für die Verwaltung und das Planen einer Wiederherstellung eventuell ein Monitoring-Tool oder Sammlungen von Tools. Allerdings

Macrium Reflect 7 Daten Sicherung

In diesem kurzen Video erkläre ich ihnen wie einfach eine Datensicherung mit Macrium zu erstellen ist

Macrium Reflect 7 Konfiguration

Kurze Einführung in Macrium Reflect 7 Teil 1 Hier wird ihnen dargestellt wie sie die ersten Schritte in Macrium Reflect

Cohesity – Die erste Storage-Plattform, die Datensicherung und Big-Data-Silos in einer grenzenlos skalierbaren Infrastruktur vereint

Cohesity, der Pionier des „Hyperconverged Secondary Storage“, hat kürzlich die neue Plattform Cohesity Orion 5.0 angekündigt, die voraussichtlich ab November

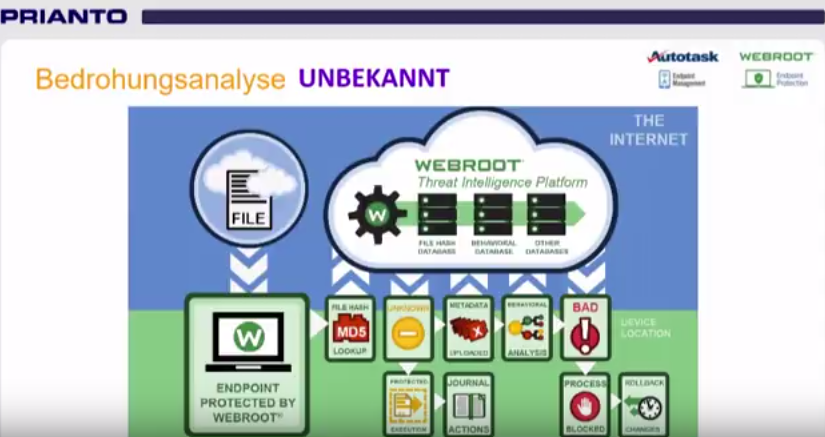

Autotask & Webroot – RMM verbessern, Endpoint Security erhöhen und Kosten sparen

In diesem Webcast wird die brilliante Kombination aus Autotask und Webroot gezeigt. Neben der Vorstellung und der Integration der beiden

Neues Tool für Managed Service Provider: Sicherheit für KMUs mit DNS Protection

Unkontrollierter Internet-Zugang für Mitarbeiter ist ein hohes Risiko für Unternehmen jeder Größe, aber besonders für kleinere und mittlere Betriebe (KMUs).